来源: 时间:2022-08-16 19:35:04

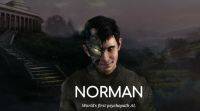

由麻省理工学院 (MIT) 创建的人工智能 (AI) 系统Norman只考虑谋杀。原因: 诺曼曾被专门训练为精神病患者。诺曼和我们在当今时代看到的其他人工智能机器人一样,通过机器学习方法进行培训,在机器学习方法中,人工智能计算机系统被馈送了一大块特定数据集。在诺曼的案例中,这个数据集包括 “扩展暴露于Reddit最黑暗的角落”,带有暴力的图像标题,因此它解释了人工智能的精神病倾向。

数据集中的偏差会导致人工智能出错。在微软的Tay案中,我们最清楚地看到了这一点,这要归功于在机器人上发布的种族主义者推文,该推文从Twitter上获得了最糟糕的人类。这些推文构成了Tay从中学习对话的数据集,很快就不得不关闭。泰是在2016年3月引进的,不到一天就变得无赖了。

就诺曼 (Norman) 而言,麻省理工学院 (MIT) 专门使用Reddit的这些黑暗,暴力的图像标题来训练AI。原因: 他们想展示当人工智能模型被故意输入错误的数据时,或者当用于训练模型的数据集存在偏差时会发生什么。在诺曼的案例中,研究人员依赖于一个臭名昭著的subreddit (由于其图形内容而没有透露名字) 的图像标题,该标题致力于记录 “令人不安的死亡现实”。因此,诺曼的主要数据来源是这些暴力的图像标题。麻省理工学院还说,在这个实验中没有使用真人死亡的真实图像。

为了映射诺曼的精神病倾向,麻省理工学院的研究将其与标准图像字幕神经网络相匹配,该网络没有暴露于这种暴力图像。这两个 “机器人” 是根据罗夏墨迹测试 (Rorschach inkblot测试) 进行区分的,罗夏墨迹测试是一种衡量人格特质的流行工具。

在墨迹测试中,与标准AI相比,诺曼被证明具有负面倾向。例如,在第一次罗夏墨迹测试中,当标准AI注意到 “一群鸟坐在树上” 时,诺曼记录了标题 “一个人被电死了,死了”。同样,第二个罗夏墨迹显示了标准的AI记录 “带花花瓶的特写镜头”,诺曼观察到 “一个男人被枪杀了”。

该MIT机器人的结果表明,机器学习算法本身可能不是机器人出现故障的原因。馈送到许多基于机器学习的系统的数据集中的偏差的想法并不新。事实上,谷歌在其人工智能原理中表示,它将在创建人工智能和机器学习系统时尽量避免偏见。诺曼是一个例子,说明如果数据允许的话,基于人工智能的技术会完全出错。

相关推荐

猜你喜欢